L’intelligence artificielle (IA) s’est rapidement développée dans les dernières années et d’importantes répercussions sociales et économiques se font déjà sentir. De nombreux scandales associés à la collecte de données ont déjà éclaboussé de grandes entreprises telles que Facebook et Amazon. Par ailleurs, l’automatisation des machines ne suscite plus seulement des craintes liées à des pertes massives d’emplois, mais aussi à l’apparition d’autres risques, comme les décisions potentiellement tendancieuses des machines. Cette croissance rapide et potentiellement invasive de l’IA génère un questionnement quant au rôle présent et futur du gouvernement fédéral dans l’encadrement de son développement.

La présente publication vise à dresser un portrait de la situation actuelle en matière d’IA, des risques qui y sont associés ainsi que des perspectives d’avenir qui s’y rattachent.

Initialement, l’une des applications courantes de l’IA était le recours à des systèmes experts programmés avec des instructions précises afin d’imiter des compétences humaines en matière de résolution de problèmes complexes. Ces systèmes étaient populaires à une époque où l’accès à des ordinateurs performants et à de grandes quantités de données était restreint 1.

Depuis plusieurs années, avec l’augmentation de la puissance des ordinateurs et de l’accessibilité à de grands ensembles de données (big data), l’application de l’IA la plus courante est l’apprentissage automatique (machine learning). Plutôt que d’être programmés pour résoudre un problème avec des instructions logiques, les algorithmes de l’apprentissage automatique classent et compilent des données pour ensuite dégager des tendances et offrir un meilleur rendement subséquemment. D’énormes quantités de données sont cependant nécessaires pour améliorer le rendement des plateformes d’IA. Par exemple, les plateformes de reconnaissance par image nécessitent des millions d’images d’un même élément pour ensuite le reconnaître. Ces techniques s’inspirent du fonctionnement du cerveau humain où l’information est stockée dans des connexions neuronales en constante évolution 2.

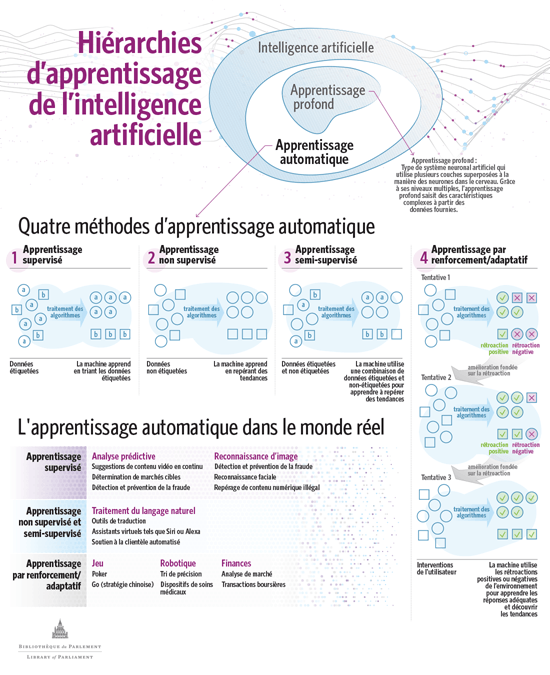

L’apprentissage automatique se divise en plusieurs en différents groupes et méthodes. Les algorithmes de l’apprentissage supervisé, non supervisé et semi‑supervisé apprennent à partir de différents ensembles de données, tandis que les algorithmes de l’apprentissage par renforcement apprennent grâce à la rétroaction positive ou négative de l’environnement. L’apprentissage profond (deep learning) est un sous‑groupe de l’apprentissage automatique qui a recours à l’apprentissage supervisé, à l’apprentissage non supervisé et parfois à l’apprentissage semi‑supervisé 3. Consultez la figure 1 pour en savoir plus au sujet de l’apprentissage automatique.

Figure 1 – Apprentissage automatique : méthodes et applications

Source : Figure préparée par l’auteure à partir de données tirées de Matthew Smith et Sujaya Neupane, Intelligence artificielle et développement humain : vers un programme de recherche, Centre de recherches pour le développement international, avril 2018; et Brookfield Institute, Intro to AI for Policymakers: Understanding the shift ![]() (931 Ko, 21 pages), mars 2018.

(931 Ko, 21 pages), mars 2018.

Les avancements de l’IA et l’accès à des mégadonnées permettent d’automatiser d’importants processus décisionnels dans divers domaines. Cette autonomisation n’est toutefois pas sans risque : le processus décisionnel des applications d’IA se doit d’être des plus transparents afin d’assurer l’impartialité des décisions. Les décideurs doivent en outre être en mesure d’expliquer le raisonnement qui a mené à une décision. D’ailleurs, en février 2019, le gouvernement du Canada a annoncé la Directive sur la prise de décision automatisée , laquelle a pour objet de veiller à ce que certains principes, comme « la transparence, la responsabilisation, la légalité et l’équité procédurale », soient respectés lors de l’usage de l’IA dans la prestation de services du gouvernement fédéral 4. Toutefois, selon l’Organisation de commerce et de développement économiques (OCDE), un défi d’importance réside dans la complexité des algorithmes de l’IA qui rend la compréhension du processus décisionnel difficile 5.

La qualité des données utilisées dans les applications de l’apprentissage automatique est donc très importante. Pourtant, ces données sont parfois incomplètes ou tendancieuses, car elles découlent de décisions prises par des humains. Les applications de l’IA font donc à la fois partie du problème et de la solution. En effet, bien que l’IA puisse aider à contrer les préjugés humains, les algorithmes utilisent les données qui leur sont fournies. Si elle utilise des données tendancieuses, l’IA risque d’exacerber les préjudices associés à l’humain 6. Par exemple, il a été démontré que les résultats d’un outil de prédiction utilisé par des juges étaient tendancieux sur le plan de la race, car l’outil se fondait sur des décisions empreintes de discrimination raciale prises antérieurement par des juges. Lorsque les préjudices sont connus, il est possible de travailler à les éliminer, mais la situation est tout autre dans le cas des préjudices inconscients. Il est à tout le moins difficile de résoudre un problème dont on ignore l’existence. Selon le rapport de l’OCDE, il est important d’être conscient des préjudices inhérents à la société ou à certains segments et de mettre en place des processus pour les contrer 7.

Compte tenu des risques associés aux processus décisionnels générés par des algorithmes automatiques, certaines personnes peuvent ne pas vouloir y être assujetties. En outre, certaines administrations ont pris des mesures pour informer la population au sujet de ces processus et lui offrir la liberté d’y être assujettie ou non. Par exemple, au sein de l’Union européenne, l’article 22 du Règlement général sur la protection des données de l’UE 8 reconnaît le droit à toute personne concernée de ne pas faire l’objet d’une décision issue exclusivement d’un traitement automatique. Au Canada, un tel droit ne semble pas être prévu dans la Loi sur la protection des renseignements personnels et documents électroniques (LPRPDE) 9, laquelle s’applique à la cueillette, l’utilisation ou la communication des renseignements personnels dans le cadre d’activités commerciales en sol canadien.

L’accès à de grandes quantités de données, bien que primordial pour le développement et le rendement de l’IA, soulève aussi de nombreux enjeux relatifs à la protection des renseignements personnels, notamment sur les plans de l’éthique et de la sécurité. Les données sont principalement collectées et stockées par des multinationales qui opèrent à partir des États‑Unis. Or, contrairement au Canada avec la LPRPDE, les États‑Unis ne disposent d’aucun cadre réglementaire uniforme pour régir la gestion des données. Les méthodes de collecte et de stockage des données ne respectent donc pas toujours la vie privée de manière transparente, ce qui peut porter atteinte à la sécurité des renseignements personnels des personnes concernées 10.

Certaines provinces ont déjà mis en place des cadres réglementaires pour protéger le stockage des données au Canada et à l’étranger. À titre d’exemple, la Personal Information Protection Act 11 de la Colombie‑Britannique et la Personal Information International Disclosure Protection Act 12 de la Nouvelle‑Écosse exigent que les instances publiques conservent au Canada les renseignements personnels collectés et qu’elles fassent en sorte que ces données ne soient pas consultées depuis l’extérieur du Canada. En Ontario, en vertu de la Loi de 2004 sur la protection des renseignements personnels sur la santé 13, les institutions (comme les hôpitaux et les pharmacies) ainsi que les mandataires (compagnies d’assurance) qui stockent des données personnelles dans le domaine de la santé doivent s’assurer que le fournisseur de services infonuagiques choisi se conforme aux lignes directrices prévues dans cette loi. Similairement, au Nouveau‑Brunswick, la Loi sur l’accès et la protection en matière de renseignements personnels sur la santé 14 exige que, dans le milieu de la santé, les données personnelles soient stockées au Canada. Par ailleurs, au Québec, la Loi sur l’accès aux documents des organismes publics et sur la protection des renseignements personnels 15 exige que tous les renseignements personnels demeurent au Québec, sauf si le fournisseur externe de services infonuagiques protège les données en vertu de dispositions qui correspondent à celles prévues dans la loi québécoise.

Différentes méthodes d’encadrement et de protection de la collecte de données pourraient être considérées. Dans son rapport de février 2018 sur la LPRPDE, le Comité permanent de l’accès à l’information, de la protection des renseignements personnels et de l’éthique recommande une réforme de la LPRPDE. Un défi de taille consiste à faire en sorte qu’un nouveau cadre réglementaire puisse s’adapter aux changements technologiques. Certains experts ajoutent que, pour être efficaces et donner suite aux enjeux qui ont une portée internationale, les normes d’encadrement et de protection doivent être mises en place non seulement à l’échelle nationale, mais aussi à l’échelle mondiale 16.

Selon plusieurs experts, l’IA a le potentiel d’évoluer grandement au cours des prochaines décennies. Le développement de l’IA est maintenant à un stade qualifié de faible (IA faible) puisqu’elle est présentement à un niveau inférieur à celui de l’intelligence humaine : elle permet de résoudre un problème ou une tâche à la fois 17. Selon certains experts, d’ici environ 30 à 50 ans, l’IA atteindra un stade qualifié de fort (IA forte), dont le niveau sera équivalent à celui de l’intelligence humaine. En atteignant ce stade, les machines autonomes auront la capacité de raisonner et de prendre des décisions. D’autres experts prévoient que l’IA atteindra ce stade dans une centaine d’années, voire plus 18. Enfin, certains envisagent que l’IA forte pourrait, hypothétiquement, dans plusieurs décennies, évoluer vers un stade de superintelligence artificielle (SIA), où l’IA serait à un niveau supérieur à celui de l’intelligence humaine et pourrait évoluer d’elle‑même 19.

Il est cependant difficile de prédire quand cette évolution aura lieu, de même que l’impact qu’elle aura. Néanmoins, certains experts affirment que l’idée d’une IA qui prend la forme de robots menaçant la société relève de la science‑fiction. Ces experts affirment en outre que le développement de l’IA faible vers l’IA forte se fera dans un avenir si lointain qu’il serait futile de légiférer à l’heure actuelle. De plus, selon eux, il pourrait s’avérer contre‑productif de légiférer au sujet d’un problème qui n’existe pas encore puisque cela pourrait limiter les progrès technologiques, alors qu’il est important de stimuler et d’encourager l’innovation 20.

D’autres experts affirment pour leur part qu’il est important de légiférer et d’encadrer le développement de l’IA pour éviter qu’elle évolue vers des applications dangereuses, car l’innovation ne doit pas se faire à l’encontre de la sécurité des citoyens. Étant donné que la mise en place d’un cadre de réglementation pourrait prendre un certain temps, il est pertinent d’y penser dès maintenant 21. D’ailleurs, le Parlement européen a adopté, en février 2017, une résolution 22 donnant suite aux recommandations de la Commission européenne concernant des règles de droit civil sur la robotique. Par cette résolution, le Parlement européen affirme qu’une approche graduelle est importante pour ne pas freiner l’innovation, tout en soulignant l’importance de commencer à étudier dès maintenant la question de la responsabilité civile. Cette question peut englober divers enjeux, notamment la question de la responsabilité juridique pour les dommages causés par un robot.

De plus, en février 2019, le Comité de la politique de l’économie numérique de l’OCDE a annoncé qu’il s’appuierait sur les recommandations d’un groupe d’experts internationaux pour élaborer les premières lignes directrices intergouvernementales en matière d’IA lors de sa prochaine réunion, en mars 2019. Ce comité prévoit en outre présenter un projet de recommandations en mai 2019 23.

Enfin, malgré l’absence de cadre réglementaire au Canada, le gouvernement fédéral octroie du financement ciblé en IA dans certains secteurs. Par exemple, dans son budget de 2017 24, il a annoncé un financement de 125 millions de dollars sur cinq ans pour sa Stratégie pancanadienne en matière d’IA, laquelle vise, entre autres, à accroître le nombre de chercheurs en IA au Canada, et à établir « un leadership éclairé d’envergure mondiale relativement aux répercussions économiques, éthiques, politiques et juridiques des percées en intelligence artificielle 25 ». Grâce à ce financement, le gouvernement fédéral a le pouvoir de prioriser des secteurs spécifiques afin de maximiser le potentiel du Canada en matière d’innovation. Toutefois, comme l’ont suggéré plusieurs experts, les gouvernements doivent être conscients des risques associés à l’IA et mettre des outils en place pour être en mesure d’y faire face.

† Les documents de la série En bref de la Bibliothèque du Parlement sont des survols de sujets d’actualité. Dans certains cas, ils donnent un aperçu de la question et renvoient le lecteur à des documents plus approfondis. Ils sont préparés par le Service d’information et de recherche parlementaires de la Bibliothèque, qui effectue des recherches et fournit des informations et des analyses aux parlementaires, ainsi qu’aux comités du Sénat et de la Chambre des communes et aux associations parlementaires, et ce, de façon objective et impartiale. [ Retour au texte ]

© Bibliothèque du Parlement